AIと聞いて思い浮かぶ中の一つに画像生成が話題になっていますね。絵が描けない人でも、文章(「黒髪 ロング 女の子」みたいな)を入力するだけで、それっぽい画像を作れるのだから驚きです。存在は知っているけど画像生成したことが無いと言う人も多いかと思います。

前回の記事(「AI画像生成初心者必見!DALL-E 3で簡単に魅力的な画像を作成」)では簡単に試せる「DALL-E 3」を使った簡単な画像生成を試してみました。

今回は一歩踏み込んだ内容で、画像生成で最も有名なStableDiffusionの環境を用意し画像生成をできるようにしようと思います。

画像生成ってどれを使ったらいいの?

前回記事のおさらいにもなりますが、AIで画像生成をするためには、特定のモデルやサービスを利用します。

以下に主要な画像生成ツールやサービスをピックアップし、それぞれの特徴を紹介します。

有名な画像生成AIモデルやツール

1. Stable Diffusion

概要: Stability AIが開発したオープンソースモデル。ローカル環境やクラウドで自由に実行可能。

メリット:

無料で利用でき、商用利用も(一部条件ありで)可能。

自分でカスタマイズしたり仕組みを理解できる。

高いクオリティの画像を生成可能。

デメリット:

環境構築が必要(ハードウェアのスペックが重要)。

初心者向けではない部分もある。

2. DALL-E 2

概要: OpenAIが提供する画像生成モデル。Web上で簡単に利用可能。

メリット:

直感的なUIで操作が簡単。

初心者でもすぐに使える。

デメリット:

APIは有料。トークン数(リクエスト数)による課金制。

動作はブラックボックスで、仕組みのカスタマイズなどは不可。

商用利用には制約がある。

3. MidJourney

概要: Discordを通じて動作する画像生成ツール。

メリット:

簡単な設定で利用可能。

高品質なアート作品を生成可能。

デメリット:

有料プランが大半を占める。

カスタマイズ性は低い。

この記事では、カスタマイズ性の高いStable Diffusionを使い画像生成を試していきます。

画像生成Webサービスと自分で環境を用意する違いとは?

現在は、上記のような強力なWebサービスやツール(DALL-E 3、MidJourneyなど)を使えば、簡単に画像を生成できます。それなら「わざわざ自分で環境を作る必要はないのでは?」と思うかもしれません。

しかし以下のポイントを考慮すると、自分で環境を用意する強みが見えてきます。

なぜWebサービスではなくローカル環境や自由な実行環境を用意するのか?

透明性と理解のため

Webサービスは動作がブラックボックスであることが多く、「どのようにして画像が生成されるのか」を理解することが困難です。

自分で環境を構築してモデルを動かすことで、アルゴリズムの仕組みや推論プロセスを知ることができます。特にエンジニアには、技術に対する深い理解が求められる場面もあるでしょう。

カスタマイズ性

Webサービスでは提供されているデフォルトのモデルをただ使うだけに留まりがちです。一方、Stable Diffusionをローカル環境で動かせば、以下が可能になります:

モデルのカスタマイズ(例: 特定の用途に特化した再訓練)。

プロンプトエンジニアリングの試み(入力を工夫して画像生成の最適化)。

特定の拡張機能(ControlNetなど)を使った特殊処理の追加。

ランニングコスト

Webサービスは有料APIやサブスクリプションプランが主流。大量の画像を生成する場合、コストが嵩む可能性があります。

自分で一度GPUを用意して環境構築をすれば、長期的には費用を抑えることが可能です。

自由度の高さ

商用利用や成果物の権利に関する規約が、Webサービスでは制限される場合があります。例えば、商業イラストやプロダクトデザインに利用する場合、規約を厳守する必要があります。

Stable Diffusionでは(一定の条件下で)商用利用も自由に行えるため、制限なく利用する際に大きな利点があります。

Webサービスを選ぶべきケースもある

ただし、以下のような場合にはWebサービスを使う選択肢も合理的です:

短時間で成果物を得たい場合。

とにかくシンプルで使いやすいものを探している。

開発スキルを必要とせず、結果だけが欲しい場合。

GPUを持っていない、あるいは環境構築に時間をかけたくない。

実行環境の選択肢を比較

Stable Diffusionを使うには環境構築が必要です。ですが、利用環境によってハードルが違います。以下で主要な環境について比較します。

1. ローカル環境で実行

メリット

一度セットアップすれば、インターネット接続なしで使える

長時間の処理でもコストがかからない

カスタマイズ性が高い(モデル改変やプラグイン導入など)

デメリット

物理マシンのスペックが高くないと動作が非常に重い

GPUがない場合は非現実的(かなり時間がかかる)

初心者にはセットアップがややハードル高め

必要スペックの目安

GPU:最低でもNVIDIA RTX 20xxシリーズ以上推奨(VRAM 6GB以上)

メモリ:16GB以上

ストレージ:10~20GB程度の空き容量

結論として、「ディープラーニングに取り組んでいて普段からGPU環境を使っている」場合に適しています。一方、カジュアルに試してみたい方には向かないと言えます。

2. クラウド環境で実行(Google Colab)

メリット

初心者でも簡単にセットアップ可能

ハードウェアの制約を気にしなくて済む

無料枠でも十分試せる(Google Colabなら時間制限内でGPU使用可)

デメリット

Colabの無料枠には制限がある(計算時間やGPUの種類など)

ネット環境に依存する

結論として、「まずは試してみたい」「環境構築に時間をかけたくない」といったライトユーザーに最適です。また、気に入ったらローカル環境へ移行できます。

この記事では、誰でも同じ条件で利用可能でGPUの制約も避けられる Google Colab を使ってStable Diffusionを動かしてみる方法を説明します。

Google ColabでStable Diffusionを試してみよう

手順

以下の手順で、Stable DiffusionをColab上で動かします。

(1) Colabノートブックの準備

まず、Google Colab用のノートブックを開きましょう。以下のリンクから直接Colabの作業ページを開けます。

(2) fast-stable-diffusionでノートブックの作成

ColabにStable Diffusionを動かすためのノートブックの準備を行います

Google Colabを開いてファイルから“ノートブックを開く”をクリック

「GitHubタブ」で “https://github.com/TheLastBen/fast-stable-diffusion.git” を入力

リポジトリを「fast-stable-diffusion」に変更

「fast-stable-diffusion_AUTOMATIC1111.ipynb」を選択

(3) ノートブックのセットアップ&起動

「fast-stable-diffusion_AUTOMATIC1111.ipynb」を選択するとノートブックが開きます

上から順に必要なものを実行していきstable-diffusionを起動します

Connect Google Drive

実行(▶︎)ボタンを押す

確認が出るので「このまま実行」

アクセス許可「Google ドライブに接続」

Install/Update AUTOMATIC1111 repo

実行(▶︎)ボタンを押す

Requirements

実行(▶︎)ボタンを押す

Model Download/Load

画像生成の学習済みのデータ(今回は使わずやります)

Download LoRA

追加データの指定ができます(今回は使わずやります)

ControlNet

拡張機能です、容量が多いので今回のColabo環境では入れずに進めます(入れなくても動作に問題はありません)

Start Stable-Diffusion

実行(▶︎)ボタンを押す

起動するとURLが表示されるるのでURLをクリックし移動します

上記点順で初回のStable-Diffusionの本体が起動ができます2回目以降は「Start Stable-Diffusion」を実行するだけで起動ができます

※ランタイムの接続が切れた場合は再度やり直しになります

web_uiで画像生成をしてみる

web_uiが起動したら環境の準備は環境です。Stable-Diffusionが利用できる状態になってますので画像生成を試してみましょう

画像生成をするには「プロンプト」(指示文)を指定して画像を生成する必要がありますプロンプトは英語で指定する必要があり、単語毎に指定をしていきます今回は試しにこのプロンプトを使ってみます a cute anime girl, wearing a school uniform, beautiful eyes, soft lighting, full body shot, standing, meadow background, highly detailed

(かわいいアニメの女の子、制服を着て、美しい目、柔らかい照明、全身ショット、立って、草原の背景、非常に詳細)

プロンプトを入力し「Generate」をクリックすることで画像が生成されます

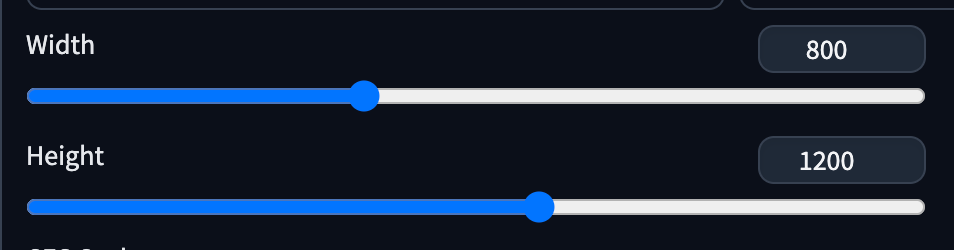

画像が生成されました初期画面の状態でプロンプトだけ指定して生成したので画像のサイズは512*512になっています 今度は画像のサイズを変更して生成してみましょう

画像サイズを変更して生成できました、サイズが大きくなったことで書き込み量が増えたおかげで先ほどよりもクリオリティが上がりました また、プロンプトは変更してませんが簡単な指示しか指定しないので生成するたびに現在の指示にそった違う画像が生成されますプロンプトには2種類ありネガティブプロンプトとい うものもあります、プロンプトには生成してほしい内容を指示しネガティブプロンプトには生成してほしくない指示をします

blurry, bad anatomy, low quality, text, watermark, extra fingers, poorly drawn

(ぼやけている、解剖学的構造が悪い、品質が低い、テキスト、透かし、余分な指、下手な描写)

試しにこのネガティブプロンプトを指定して生成してみましょう

先ほどよりも画像としてクオリティが上がった感じがしますね。プロンプトとネガティブプロンプトを使いこなすことで目的あった画像を生成することができます、それぞれの指定を変更したり調整していくことでクオリティをあげることもできます

今回のまとめ

今回は誰でも同じ条件でStable Diffusionの環境を構築できるようにGoogle Colabを使って解説しました。 Stable Diffusionは非常に人気があり画像生成といえば8割以上はStable Diffusionを利用し生成されていると言っても過言ではないぐらい人気があります。Stable Diffusionは高性能なGPUが必要になるため、環境構築は一つのハードルとなっています。 今回はGoogle Colabを利用して環境を用意しましたが無料枠で利用できるコンピューティングユニットの制限がある為、Google Colabで利用する場合はColab Proにプランのアップデートを検討することをおすすめします。より本格的に画像生成をやりたい場合は制限や料金を気にすることなく利用できカスタマイズが容易であるローカル環境を高性能なPC(GPU)を用意し利用するのが理想的です。 今回はStable Diffusionの触り始めということで導入から簡単な生成だけでしたのでスキップしましたが、学習済みのモデルを使う、Lora(追加学習データ)を扱うことでさらに目的にあった高品質が画像生成をすることもできます。興味がありましたら次回の記事でお会いできればと思います。皆さんも良いAIライフを!

%20(1).png)